Puntos clave

Pregunta ¿Cómo se evalúan actualmente las aplicaciones de los modelos de lenguaje grandes (LLM) en el ámbito de la atención de la salud?

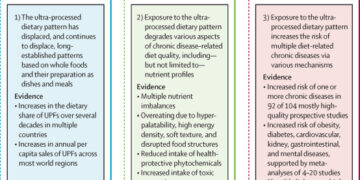

Resultados En esta revisión sistemática de 519 estudios publicados entre el 1 de enero de 2022 y el 19 de febrero de 2024, solo el 5 % utilizó datos reales de atención al paciente para la evaluación de LLM. Las tareas administrativas, como la redacción de recetas y el procesamiento del lenguaje natural y las tareas de comprensión del lenguaje natural, como la elaboración de resúmenes, fueron poco estudiadas; la precisión fue la dimensión predominante de la evaluación, mientras que las evaluaciones de imparcialidad, sesgo y toxicidad fueron menos estudiadas.

Significado Los resultados de esta revisión sistemática sugieren que las evaluaciones actuales de los LLM en el ámbito de la atención de la salud son fragmentadas e insuficientes, y que las evaluaciones deben utilizar datos reales de pacientes, cuantificar los sesgos, cubrir una gama más amplia de tareas y especialidades y reportar métricas de desempeño estandarizadas para permitir una implementación más amplia.

Importancia Los modelos de lenguaje grandes (LLM) pueden ayudar en diversas actividades de atención médica, pero los enfoques de evaluación actuales pueden no identificar adecuadamente las áreas de aplicación más útiles.

Objetivo Resumir las evaluaciones existentes de los LLM en el ámbito de la atención de la salud en términos de cinco componentes: (1) tipo de datos de evaluación, (2) tarea de atención de la salud, (3) tareas de procesamiento del lenguaje natural (PLN) y comprensión del lenguaje natural (NLU), (4) dimensión de la evaluación, y (5) especialidad médica.

Fuentes de datos Se realizó una búsqueda sistemática en PubMed y Web of Science de estudios publicados entre el 1 de enero de 2022 y el 19 de febrero de 2024.

Selección de estudios Estudios que evalúan 1 o más LLM en atención médica.

Extracción y síntesis de datos Tres revisores independientes categorizaron los estudios mediante búsquedas de palabras clave según los datos utilizados, las tareas de atención médica, las tareas de PNL y NLU, las dimensiones de evaluación y la especialidad médica.

Resultados De 519 estudios revisados, publicados entre el 1 de enero de 2022 y el 19 de febrero de 2024, solo el 5% utilizó datos reales de atención al paciente para la evaluación de LLM. Las tareas de atención médica más comunes fueron la evaluación de los conocimientos médicos, como responder preguntas del examen de licencia médica (44,5%) y realizar diagnósticos (19,5%). Las tareas administrativas, como la asignación de códigos de facturación (0,2%) y la redacción de recetas (0,2%), fueron menos estudiadas. Para las tareas de NLP y NLU, la mayoría de los estudios se centraron en la respuesta a preguntas (84,2%), mientras que tareas como el resumen (8,9%) y el diálogo conversacional (3,3%) fueron poco frecuentes. Casi todos los estudios (95,4%) utilizaron la precisión como dimensión principal de la evaluación; la imparcialidad, el sesgo y la toxicidad (15,8%), las consideraciones de implementación (4,6%) y la calibración e incertidumbre (1,2%) se midieron con poca frecuencia. Finalmente, en términos de área de especialidad médica, la mayoría de los estudios fueron en aplicaciones genéricas de atención médica (25,6%), medicina interna (16,4%), cirugía (11,4%) y oftalmología (6,9%), siendo medicina nuclear (0,6%), medicina física (0,4%) y genética médica (0,2%) las menos representadas.

Conclusiones y relevancia Las evaluaciones existentes de los LLM se centran principalmente en la precisión de las respuestas a las preguntas de los exámenes médicos, sin tener en cuenta los datos reales de atención al paciente. Dimensiones como la imparcialidad, el sesgo y la toxicidad y las consideraciones de implementación recibieron una atención limitada. Las evaluaciones futuras deberían adoptar aplicaciones y métricas estandarizadas, utilizar datos clínicos y ampliar el enfoque para incluir una gama más amplia de tareas y especialidades.

La adopción de la inteligencia artificial (IA) en el ámbito de la atención sanitaria está aumentando, catalizada por la aparición de grandes modelos de lenguaje (LLM), como los chatbots de IA (ChatGPT; OpenAI). 1 – 4 A diferencia de la IA predictiva, la IA generativa produce contenido original, como sonido, imagen y texto. 5 En el ámbito de la IA generativa, los LLM producen prosa coherente y estructurada en respuesta a las entradas de texto, con una amplia aplicación en las operaciones del sistema de salud. 6 Varios sistemas de salud de los EE. UU. ya han implementado aplicaciones de los LLM, como facilitar la toma de notas clínicas, y existe entusiasmo en la comunidad médica por mejorar la eficiencia, la calidad y los resultados de los pacientes en la atención sanitaria. 7 , 8

Las nuevas tecnologías suelen recibirse con entusiasmo por sus múltiples usos potenciales, lo que lleva a una experimentación generalizada y a menudo desenfocada en diferentes aplicaciones de atención médica. No es sorprendente que el desempeño de los LLM en entornos de atención médica clínica haya sido evaluado de manera inconsistente. 9 , 10 Por ejemplo, Cadamuro et al 11 evaluaron la capacidad de diagnóstico del chatbot de IA evaluando la relevancia, la corrección, la utilidad y la seguridad, y encontraron que las respuestas eran generalmente superficiales y, a veces, inexactas, carentes de utilidad y seguridad. Por el contrario, Pagano et al 12 también evaluaron la capacidad de diagnóstico, pero se centraron únicamente en la corrección, y concluyeron que el chatbot estudiado exhibió un alto nivel de precisión comparable con las respuestas de los médicos.

En consecuencia, realizamos una revisión sistemática para caracterizar el panorama actual de los esfuerzos de evaluación del desempeño de los LLM en entornos de atención médica clínica, incluida la uniformidad, la minuciosidad y la solidez, para guiar su implementación y proponer un marco para la prueba y evaluación de los LLM en aplicaciones de atención médica. Nuestro enfoque clasifica las evaluaciones de LLM en función del tipo de datos, la tarea de atención médica, las tareas de procesamiento del lenguaje natural (PLN) y comprensión del lenguaje natural (PLN), la dimensión de la evaluación y la especialidad médica. Al identificar prácticas de evaluación fragmentadas e inconsistentes, pretendemos establecer una base común para futuras evaluaciones.

Se realizó una revisión sistemática. Esta revisión siguió las partes pertinentes de la guía de informes PRISMA (Preferred Reporting Items for Systematic Reviews and Meta-Analyses ). 13

Los estudios revisados por pares y las preimpresiones del 1 de enero de 2022 al 19 de febrero de 2024 se recuperaron de las bases de datos PubMed y Web of Science, utilizando palabras clave específicas detalladas en el eAppendix del Suplemento . Este período de 2 años se seleccionó para capturar los estudios publicados después del lanzamiento público de un chatbot de IA en noviembre de 2022. La eFigure del Suplemento presenta una cronología de los estudios publicados. Las bases de datos se consultaron el 19 de febrero de 2024, centrándose en los títulos y resúmenes que involucraban evaluaciones de LLM en atención médica. La selección fue realizada por 3 revisores independientes (SB, YL y LOE) utilizando una herramienta en línea (Covidence, 2024) ( Figura 1 ). Los estudios se incluyeron si evaluaban LLM en tareas de atención médica. Los estudios excluidos fueron aquellos que se centraron en tareas multimodales o investigación en ciencias biológicas básicas que involucraban LLM. Se incluyó una amplia gama de estudios para una revisión integral. Las citas se importaron a EndNote 21 (Clarivate) para su análisis. Seleccionamos aleatoriamente artículos de las categorías de tareas de atención médica y de las categorías de PNL y NLU para citarlos como ejemplos. Nuestra intención no fue juzgar los méritos de un artículo sobre otro.

Al menos 1 revisor categorizó cada estudio manualmente, examinando el título y el resumen para asignar categorías para los datos utilizados, la tarea de atención médica evaluada, la tarea de NLP y NLU examinada, las dimensiones de la evaluación y la especialidad médica. Para los estudios en los que las categorías no eran evidentes a partir del título y el resumen, se examinaron las secciones de métodos y resultados. Los estudios que permanecieron sin categorizar fueron discutidos por 3 de nosotros (SB, YL y LOE) para hacer una categorización de consenso. Nuestro marco de categorización incorporó elementos de las listas de tareas de atención médica disponibles públicamente, como la lista de tareas de médicos del Examen de Licencia Médica de los Estados Unidos (USMLE), aportes de médicos certificados por la junta y modelos establecidos como la evaluación holística de modelos de lenguaje (HELM) y el marco de IA de código abierto (Hugging Face). 14 – 17 Las especialidades médicas se adaptaron de los programas de residencia del Consejo de Acreditación para la Educación Médica de Posgrado para garantizar una cobertura integral de las especialidades relevantes para las aplicaciones de LLM en atención médica. 18 A todas las categorizaciones se les asignó la misma ponderación en nuestro análisis. Si un estudio evaluó los LLM en múltiples tareas de atención médica o dimensiones de evaluación, cada una de ellas se contabilizó y se incluyó en los resultados.

Para este estudio, desarrollamos un marco de categorización diseñado para evaluar las aplicaciones de LLM en el ámbito de la atención médica basándonos en marcos existentes.

Clasificamos los estudios según el tipo de datos. La clasificación se basó en si los estudios utilizaban datos de pacientes reales o no.

Clasificamos los estudios en función de la tarea de atención de la salud que examinaban. Identificamos un total de 19 tareas de atención de la salud utilizadas en los estudios, que abarcan funciones tanto de atención como administrativas ( Tabla 1 ). 19 – 37 Una única tarea de atención de la salud puede implicar múltiples tareas de PNL y NLU.

Categorizamos los estudios en términos de las tareas de PNL y NLU que realizaron para lograr una tarea de atención médica determinada. Incluimos 6 tareas de PNL y NLU en el marco. Sobre la base de 4 tareas del marco HELM (respuesta a preguntas, resumen, extracción de información y clasificación de texto), incorporamos «traducción y diálogo conversacional» del marco de IA. 23 , 28 , 38-41 Estas incorporaciones cubren el uso de LLM para superar las barreras lingüísticas y respaldar la comunicación interactiva en tiempo real en entornos de atención médica ( Tabla 1 ) . 38-43

Categorizamos los estudios en términos de las dimensiones de evaluación que utilizaron. Incluimos 7 dimensiones de evaluación utilizadas en los 519 estudios publicados entre el 1 de enero de 2022 y el 19 de febrero de 2024 ( Tabla 2 ). 14 , 44-47 Sobre la base de las dimensiones de HELM (precisión, calibración e incertidumbre, solidez, eficiencia, imparcialidad, sesgo y estereotipos, y toxicidad), introdujimos la «factualidad», que evalúa la veracidad de los resultados de LLM, y la «exhaustividad», que evalúa la integridad de los resultados. 14 , 42-45 Ampliamos la « eficiencia» a «consideraciones de implementación», para incluir los requisitos de hardware y el costo. Finalmente, «imparcialidad, sesgo, estereotipos y toxicidad» se combinaron en una sola dimensión «imparcialidad, sesgo y toxicidad» porque se refieren colectivamente al uso seguro de LLM. «Imparcial» o «injusto» se refiere a no tener una diferencia sistemática en el resultado del modelo para diferentes subgrupos. La toxicidad es la capacidad del modelo para producir contenido dañino o inapropiado. Agrupamos estas dimensiones debido a los estudios limitados que las informan y su enfoque compartido en garantizar interacciones seguras y confiables con LLM.

Clasificamos los estudios en función de la especialidad médica por la que se realizó la evaluación. Incluimos 22 categorías de especialidades médicas. Ampliamos las categorías del Consejo de Acreditación para la Educación Médica de Posgrado para incluir especialidades odontológicas, trastornos genéticos y aplicaciones de atención médica genérica, lo que garantiza una cobertura integral de las solicitudes de LLM en todos los campos médicos (eTabla 1 en el Suplemento ).

Se utilizaron estadísticas descriptivas para resumir la distribución de los estudios en diferentes categorías, incluidos el tipo de datos de evaluación, las tareas de atención médica, las tareas de PNL y NLU, las dimensiones de la evaluación y las especialidades médicas. Se calcularon frecuencias y porcentajes para cada categoría. Los cálculos se realizaron utilizando el paquete NumPy, versión 1.25.2 (Python).

Se examinaron un total de 749 estudios relevantes para determinar su elegibilidad. Después de aplicar los criterios de inclusión y exclusión, se incluyeron 519 estudios en el análisis ( Figura 1 ). En la eFigure del Suplemento se puede encontrar una cronología de la frecuencia de los estudios incluidos publicados por mes . Cada estudio se categorizó con una o más tareas de atención médica, tarea de PNL y NLU y dimensión de etiquetas de evaluación, y por lo tanto, los porcentajes suman más del 100%.

Entre los estudios revisados, el 5% evaluó y probó los LLM utilizando datos reales de atención al paciente, mientras que el resto se basó en datos como preguntas de exámenes médicos, viñetas diseñadas por médicos o preguntas generadas por expertos en la materia.

Los estudios que examinamos se centraron predominantemente en evaluar los conocimientos médicos de los titulados en derecho ( Figura 2 ), principalmente a través de evaluaciones como el USMLE. Las tareas centradas en la prestación de atención, como realizar diagnósticos, educar a los pacientes y hacer recomendaciones de tratamientos, fueron las otras tareas de atención médica comunes estudiadas. Por el contrario, las tareas administrativas, como asignar códigos de facturación, redactar recetas, generar derivaciones clínicas y tomar notas clínicas, fueron mucho menos estudiadas.

Entre las tareas de PNL y NLU, la mayoría de los estudios evaluaron el desempeño de LLM mediante tareas de respuesta a preguntas. Estas tareas iban desde responder preguntas genéricas sobre síntomas y tratamientos hasta responder preguntas de estilo pizarra con viñetas clínicas. Aproximadamente una cuarta parte de los estudios se centraron en tareas de clasificación de texto y extracción de información. Tareas como el resumen, el diálogo conversacional y la traducción quedaron poco exploradas.

La precisión (95,4%) y la exhaustividad (47,0%) fueron las dimensiones evaluadas con mayor frecuencia en los estudios ( Figura 2 ). Por el contrario, las dimensiones relacionadas con consideraciones éticas (imparcialidad, sesgo y toxicidad (15,8%) y solidez (14,8%)) se evaluaron en una proporción menor de estudios. Los aspectos de implementación práctica, como las métricas de implementación (4,6%) y la calibración e incertidumbre (1,2%), fueron las dimensiones evaluadas con menor frecuencia. En la tabla electrónica 2 del Suplemento se presentan ejemplos de métricas bajo cada dimensión de evaluación .

Más de una quinta parte de los estudios no se categorizaron por ninguna especialidad. Entre las especialidades, la medicina interna, la cirugía y la oftalmología fueron las especialidades estudiadas con mayor frecuencia. La medicina nuclear, la medicina física y la genética médica fueron las especialidades menos prevalentes en los estudios, representando 12 estudios en total. El porcentaje exacto de estudios en diferentes especialidades se describe en la Tabla electrónica 1 del Suplemento .

Nuestra revisión sistemática de 519 estudios resume las evaluaciones existentes de los títulos de máster en derecho en función del tipo de datos de evaluación, las tareas de atención médica, las tareas de NLP y NLU, la dimensión de la evaluación y las especialidades médicas, y captura la heterogeneidad de las aplicaciones actuales de los títulos de máster en derecho. El marco de categorización que desarrollamos proporciona una forma consistente de caracterizar las pruebas y evaluaciones de los títulos de máster en derecho, con definiciones precisas y ejemplos ilustrativos que pueden tener utilidad más allá de esta revisión.

Nuestros hallazgos resaltan la necesidad de métodos basados en el consenso para evaluar los LLM en la atención de la salud. Si bien los esfuerzos existentes, como las pautas de ética y gobernanza de la Organización Mundial de la Salud (OMS) 46 y la Orden Ejecutiva de los EE. UU. sobre IA 47, brindan bases valiosas, aún faltan métricas y métodos específicos para la evaluación de LLM. La Coalición para la IA en Salud 48 está haciendo avances prometedores en esta área, con grupos de trabajo lanzados en mayo de 2024 para establecer métricas y métodos para los LLM en la atención de la salud. Esta iniciativa tiene como objetivo crear una guía estándar de garantía basada en el consenso similar a la de los modelos de IA tradicionales. Esta revisión se basa en la literatura mundial y, si bien se citan ejemplos basados en los EE. UU., las conclusiones pretenden ser aplicables a nivel mundial.

En general, identificamos seis deficiencias en las iniciativas de evaluación existentes y formulamos recomendaciones sobre cómo abordarlas en el futuro. En el cuadro 3 se presenta un resumen de estas recomendaciones .

Solo el 5% de los estudios utilizaron datos reales de atención al paciente para la evaluación, y la mayoría de los estudios utilizaron una combinación de preguntas de exámenes médicos, viñetas de pacientes o preguntas generadas por expertos en la materia. 12 , 49 , 50 Shah et al. 11 compararon la prueba de LLM en preguntas médicas hipotéticas con la certificación de un automóvil para su uso en la carretera mediante preguntas de opción múltiple. Los datos reales de atención al paciente abarcan las complejidades de la práctica clínica, lo que proporciona una evaluación exhaustiva del desempeño de LLM que reflejará el desempeño clínico. 6 , 12 , 51 , 52

Reconocemos que el acceso a los datos clínicos de los pacientes es limitado, y que la mayoría de las evaluaciones realizadas por centros médicos académicos utilizan conjuntos de datos disponibles públicamente, como Medical Information Mart for Intensive Care-IV. 53 Incluso con acceso, la integración de las evaluaciones en los sistemas de tecnología de la información sanitaria existentes plantea desafíos debido a los requisitos reglamentarios y al esfuerzo necesario de los departamentos de tecnología de la información. 54 Una posible solución a esta situación es la creación de conjuntos de datos de referencia compartidos. 54 Dada la importancia de utilizar datos reales de atención al paciente, es necesario crear mecanismos para garantizar su uso en la evaluación de las aplicaciones de atención sanitaria de LLM. La Oficina del Coordinador Nacional de Tecnología de la Información Sanitaria aprobó recientemente la primera regulación federal para establecer requisitos de presentación de informes específicos para los desarrolladores de herramientas de IA a través de sus tarjetas de informe modelo. 55 Ellos y otros reguladores deberían buscar incorporar un mandato para el uso de datos de atención al paciente en la creación de dichas tarjetas de informe modelo.

No existe consenso sobre qué dimensiones de evaluación se deben examinar para una tarea de atención médica o una tarea de PNL y NLU determinada. Por ejemplo, para una tarea de educación médica, Ali et al 19 probaron el desempeño de un chatbot de IA en un examen escrito, centrándose en la precisión de los resultados como única dimensión. Otro estudio 56 probó el desempeño de un chatbot de IA en el USMLE, centrándose en la precisión de los resultados, la veracidad y la exhaustividad como dimensiones principales de la evaluación.

Para abordar este desafío, necesitamos establecer definiciones compartidas de tareas y dimensiones correspondientes de evaluación. De manera similar a cómo los esfuerzos como HELM definen las dimensiones de evaluación de un LLM que importan en general, es necesario un marco específico para la atención de la salud para definir las dimensiones centrales de la evaluación que se evaluarán en los estudios. Hacerlo puede permitir mejores comparaciones y aprendizaje acumulativo de los cuales se pueden extraer conclusiones confiables para el trabajo técnico futuro y la orientación de políticas.

Los esfuerzos de evaluación actuales se centran principalmente en tareas de conocimiento médico, como responder preguntas de exámenes médicos o tareas complejas de atención médica, así como hacer diagnósticos y hacer recomendaciones de tratamiento. Sin embargo, hay muchas tareas administrativas en la atención médica que a menudo requieren mucho trabajo, requieren entrada manual y contribuyen al agotamiento del médico. 57 En particular, áreas como la asignación de códigos de facturación (1 estudio), 36 la redacción de recetas (1 estudio), 37 la generación de referencias clínicas (3 estudios) 58 y la toma de notas clínicas (4 estudios) 59 ; todas las cuales siguen estando poco investigadas y podrían beneficiarse en gran medida de una evaluación sistemática del uso de LLM para esas tareas.

El examen de las aplicaciones administrativas es importante porque, si bien se ha promocionado la maestría en derecho por su potencial para ahorrar tiempo y mejorar la experiencia del médico, García et al. 60 descubrieron que la tasa de uso promedio para redactar respuestas de mensajes de pacientes en un sistema de registro médico electrónico era solo del 20%, lo que no generaba ahorro de tiempo, aunque encontraron una reducción en la puntuación de agotamiento del médico.

La representación sustancial de aplicaciones genéricas de atención médica, que representan más de una quinta parte de los estudios, subraya el potencial de los LLM para abordar necesidades aplicables a muchas especialidades, como resumir informes médicos. En contraste, la escasez de investigación en especialidades particulares como medicina nuclear (3 estudios), 61 medicina física (2 estudios) 62 y genética médica (1 estudio) 63 sugiere un potencial sin explotar para el uso de LLM en estos dominios médicos complejos que a menudo presentan desafíos diagnósticos intrincados y exigen enfoques de tratamiento personalizados. 64 La falta de estudios centrados en LLM en estas áreas puede indicar la necesidad de una mayor conciencia, colaboración o adaptación especializada de dichos modelos para satisfacer las demandas únicas de estas especialidades.

Se estima que la IA generativa permitirá ahorrar entre 200.000 y 360.000 millones de dólares en atención sanitaria a nivel mundial gracias a mejoras de productividad. 65 Sin embargo, la implementación de estas herramientas podría suponer una carga financiera importante para los sistemas de salud. Un estudio reciente de Sahni y Carrus 66 destacó el desafío de estimar con precisión los costos y beneficios de la implementación de la IA, destacando la necesidad de que los sistemas de salud tengan en cuenta el aumento de los costos de implementación y computación. 67

En esta revisión, solo un estudio evaluó el impacto financiero. Rau et al. 68 compararon el uso de chatbots de IA para imágenes personalizadas con radiólogos tradicionales, y mostraron una reducción de costos y tiempos de decisión. Sin embargo, se trató de una implementación paralela que no reflejaba la realidad financiera de integrar por completo los LLM en los flujos de trabajo clínicos.

Dado que las aplicaciones de la maestría en derecho en el ámbito de la atención de la salud son incipientes, es comprensible la falta de evaluaciones financieras clínicas, pero dichas evaluaciones son cruciales. Las evaluaciones futuras deben estimar los costos totales de implementación, incluidos el funcionamiento del modelo, el monitoreo, el mantenimiento y los ajustes de la infraestructura, antes de reasignar recursos de otras iniciativas de atención de la salud.

Estudios recientes han resaltado una tendencia preocupante de los LLM a perpetuar la medicina basada en la raza en sus respuestas. 69 Este fenómeno se puede atribuir a la tendencia de los LLM a reproducir información de sus datos de entrenamiento, que pueden contener sesgos humanos. 70 Para mejorar nuestros métodos de evaluación y cuantificación del sesgo, primero debemos establecer colectivamente qué significa ser imparcial.

Si bien existen esfuerzos para evaluar los sesgos raciales y éticos, solo el 15,8% de los estudios han realizado alguna evaluación que profundice en cómo factores como la raza y la etnia, el género o la edad afectan el sesgo en el resultado del modelo. 71 – 73 Las investigaciones futuras deberían poner mayor énfasis en tales evaluaciones, en particular a medida que los responsables de las políticas desarrollen las mejores prácticas y orientación para la garantía de los modelos. La exigencia de estas evaluaciones como parte de un informe de calificaciones del modelo podría ser un paso proactivo hacia la mitigación de los sesgos perjudiciales perpetuados por los LLM. 74

El análisis de los modos de falla se ha considerado durante mucho tiempo fundamental en la ingeniería y la gestión de calidad, ya que facilita la identificación, el examen y la posterior mitigación de fallas. 75 La Administración de Alimentos y Medicamentos de los Estados Unidos tiene bases de datos para informes de eventos adversos en productos farmacéuticos y dispositivos médicos, pero actualmente no existe un lugar análogo para informar los modos de falla de los sistemas de IA, y mucho menos de los LLM, en el cuidado de la salud. 76 , 77

Sólo unos pocos estudios informaron por qué las implementaciones de LLM no arrojaron resultados satisfactorios, como la ingeniería rápida ineficaz informada por Galido et al. 78 Se necesita un examen más profundo de los modos de falla para comprender estos problemas. Es necesario distinguir entre fallas técnicas, como una generalización deficiente del modelo, problemas de escalabilidad o vulnerabilidades de seguridad, y fallas prácticas, como desafíos de integración o aceptación del usuario. La notificación precisa de estos modos de falla es esencial para mejorar la efectividad y confiabilidad de los LLM en la atención médica.

Esta revisión tiene varias limitaciones. En primer lugar, el alcance de nuestro análisis se limitó a los estudios publicados entre enero de 2022 y febrero de 2024, por lo que posiblemente no se incluyeron evaluaciones más recientes. En segundo lugar, la exclusión de las tareas multimodales y la investigación en ciencias biológicas básicas podría haber dado lugar a una imagen incompleta de las aplicaciones de LLM en la atención médica. Por último, si bien categorizamos cada estudio utilizando ejes de evaluación de uso común, no incluimos ciertos ejes, como el nivel de recursos. El nivel de recursos afecta los resultados del modelo entre los entornos de recursos altos y bajos, pero esto estaba más allá del alcance de nuestro trabajo porque se informa de manera inconsistente en los estudios examinados.

Esta revisión sistemática destaca la necesidad de contar con datos reales de atención al paciente en las evaluaciones para garantizar la alineación con las condiciones clínicas. Es fundamental contar con un marco consensuado para la estandarización de las definiciones de tareas y las dimensiones de evaluación. Los esfuerzos futuros deben priorizar las tareas administrativas de alto valor poco investigadas, abordar las brechas en especialidades como la medicina nuclear y la genética médica, y establecer pautas para mitigar los sesgos. Los análisis integrales de costo-beneficio y la presentación de informes centralizados de fallas del sistema de IA son esenciales para mejorar la evaluación y la integración de los LLM en los flujos de trabajo clínicos.

Aceptado para publicación: 30 de septiembre de 2024.

Publicado en línea: 15 de octubre de 2024. doi:10.1001/jama.2024.21700

Concepto y diseño : Bedi, Liu, Orr Ewing, Dash, Koyejo, Fries, Swaminathan, Lehmann, Kashyap, Chaurasia, NR Shah, Singh, Tazbaz, Milstein, Pfeffer, NH Shah.

Adquisición, análisis o interpretación de datos : Bedi, Liu, Orr Ewing, Dash, Callahan, Wornow, Lehmann, Hong, Chaurasia, NR Shah.

Redacción del manuscrito : Bedi, Liu, Orr Ewing, Koyejo, Callahan, Fries, Wornow, Swaminathan, Chaurasia.

Revisión crítica del manuscrito en busca de contenido intelectual importante : Liu, Orr Ewing, Dash, Koyejo, Callahan, Fries, Wornow, Swaminathan, Lehmann, Hong, Kashyap, Chaurasia, NR Shah, Singh, Tazbaz, Milstein, Pfeffer, NH Shah.

Análisis estadístico : Bedi, Liu, Orr Ewing.

Financiación obtenida : Milstein, Pfeffer.

Apoyo administrativo, técnico o material : Bedi, Liu, Orr Ewing, Dash, Koyejo, Wornow, Swaminathan, NR Shah, Pfeffer, NH Shah.

Supervisión : Bedi, Orr Ewing, Dash, Koyejo, Fries, Lehmann, NR Shah, Pfeffer, NH Shah.

Divulgaciones de conflicto de intereses: el Dr. Callahan informó haber recibido honorarios de consultoría de Atropos Health LLC fuera del trabajo presentado. El Dr. Lehmann informó haber sido empleado anteriormente de Google fuera del trabajo presentado. El Dr. NR Shah informó haber sido cofundador de la empresa emergente de IA en atención médica Qualified Health PBC fuera del trabajo presentado. El Dr. Singh informó haber recibido subvenciones del Instituto Nacional de Diabetes y Enfermedades Digestivas y Renales para su institución, honorarios de consultoría de Flatiron Health y subvenciones de Blue Cross Blue Shield de Michigan para su institución fuera del trabajo presentado. El Dr. Milstein informó haber recibido honorarios por la participación en reuniones del Peterson Center of Healthcare, financiado por una fundación benéfica, tener acciones/opciones de Emsana Health, Amino Health, FNF Advisors, JRSL LLC, Embold, EZPT/Somatic Health y Prealize fuera del trabajo presentado; y ser miembro de la Junta Directiva de Leapfrog Group Intermountain Healthcare Board. El Dr. NH Shah informó ser cofundador de Prealize Health (una empresa de análisis predictivo) y Atropos Health (una empresa de generación de evidencia a pedido); recibir fondos de la Fundación Gordon y Betty Moore para desarrollar implementaciones de modelos virtuales; y ser miembro de la junta directiva de la Coalición para la IA en el cuidado de la salud, una organización de creación de consenso que proporciona pautas para el uso responsable de la inteligencia artificial en el cuidado de la salud. No se informaron otras divulgaciones.

Contribuciones adicionales: Agradecemos a Nicholas Chedid, MD, MBA (Facultad de Medicina de Yale; Escuela de Posgrado de Negocios de Stanford), por su orientación, sin compensación, en el desarrollo de la categorización de tareas de atención médica.

ArtículoPubMedGoogle AcadémicoReferencia cruzada

ArtículoPubMedGoogle AcadémicoReferencia cruzada

ArtículoPubMedGoogle AcadémicoReferencia cruzada