NOTA de la Red: Desde la Red compartimos que es muy importante el problema de la IA en la salud y la atención de la salud, y que conlleva riesgos y beneficios. En general parece que se avecinan más riesgos que beneficios, si no analizamos el tema con profundidad. Si existe el problema de la salud y la atención de la salud con el capitalismo, mucho más parece serlo en lo que Varoufakis llama tecnofeudalismo

Importancia: La inteligencia artificial (IA) está transformando la salud y la atención sanitaria a una escala sin precedentes. Si bien los beneficios potenciales son enormes, también lo son los riesgos. La Cumbre de JAMA sobre IA debatió cómo desarrollar, evaluar, regular, difundir y supervisar la IA en el ámbito de la salud y la atención sanitaria.

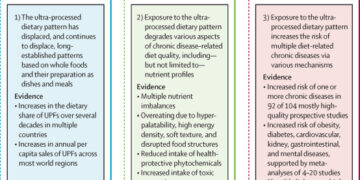

Observaciones La IA en salud y atención médica es muy amplia e incluye herramientas clínicas (p. ej., alertas de sepsis o software de detección de retinopatía diabética), tecnologías utilizadas por personas con problemas de salud (p. ej., aplicaciones móviles de salud), herramientas utilizadas por los sistemas de atención médica para mejorar las operaciones comerciales (p. ej., gestión del ciclo de ingresos o programación) y herramientas híbridas que respaldan tanto las operaciones comerciales (p. ej., documentación y facturación) como las actividades clínicas (p. ej., sugerir diagnósticos o planes de tratamiento). Muchas herramientas de IA ya están ampliamente adoptadas, especialmente para imágenes médicas, salud móvil, operaciones comerciales de atención médica y funciones híbridas como la prescripción de visitas ambulatorias. Todas estas herramientas pueden tener efectos importantes en la salud (buenos o malos), pero estos efectos a menudo no se cuantifican porque las evaluaciones son extremadamente difíciles o no son necesarias, en parte porque muchas están fuera de la supervisión regulatoria de la Administración de Alimentos y Medicamentos de los EE. UU. Un desafío importante en la evaluación es que los efectos de una herramienta dependen en gran medida de la interfaz humano-computadora, la capacitación del usuario y el entorno en el que se utiliza la herramienta. Numerosos esfuerzos establecen estándares para el uso responsable de la IA, pero la mayoría se centra en la monitorización de la seguridad (p. ej., la detección de alucinaciones en modelos) o el cumplimiento institucional con diversas medidas de proceso, y no abordan la eficacia (es decir, la demostración de mejores resultados). Garantizar que la IA se implemente de forma equitativa y que mejore los resultados sanitarios o, si se mejora la eficiencia de la atención sanitaria, que lo haga de forma segura, requiere avances en cuatro áreas. En primer lugar, se necesita la participación de múltiples partes interesadas a lo largo de todo el ciclo de vida del producto. Este esfuerzo incluiría una mayor colaboración entre los usuarios finales y los desarrolladores en la creación inicial de las herramientas y una mayor colaboración entre los desarrolladores, los organismos reguladores y los sistemas de atención sanitaria en la evaluación de las herramientas a medida que se implementan. En segundo lugar, se deben desarrollar y difundir herramientas de medición para la evaluación y la monitorización. Más allá de las iniciativas propuestas de monitorización y certificación, esto requerirá nuevos métodos y conocimientos especializados que permitan a los sistemas de atención sanitaria realizar o participar en evaluaciones de eficacia rápidas, eficientes y sólidas. La tercera prioridad es la creación de una infraestructura de datos representativa a nivel nacional y un entorno de aprendizaje que respalde la generación de conocimiento generalizable sobre los efectos de las herramientas de IA en la salud en diferentes entornos. En cuarto lugar, se debería promover una estructura de incentivos, utilizando las fuerzas del mercado y las herramientas políticas, para impulsar estos cambios.

Conclusiones y relevancia: La IA revolucionará todos los aspectos de la salud y la prestación de servicios de salud en los próximos años. Dados los numerosos problemas de larga data en la atención médica, esta disrupción representa una oportunidad increíble. Sin embargo, la probabilidad de que esta disrupción mejore la salud para todos dependerá en gran medida de la creación de un ecosistema capaz de generar conocimiento rápido, eficiente, sólido y generalizable sobre las consecuencias de estas herramientas en la salud.

La naturaleza amplia y el uso de la inteligencia artificial (IA)

-

La IA es un término amplio; durante décadas, consistió en representaciones de conocimiento basadas en reglas (software que codificaba enunciados lógicos como «si X, entonces Y») y modelos de predicción (redes neuronales artificiales), que ofrecían resultados similares a los del software informático tradicional y los modelos estadísticos. Sin embargo, con los avances en la potencia computacional y la disponibilidad de conjuntos de datos más grandes y complejos en las últimas dos décadas, la IA evolucionó rápidamente. Los tres avances siguientes ayudan a diferenciarla de las tecnologías digitales anteriores:

-

Aprendizaje profundo: desarrollo de redes neuronales más profundas y complejas capaces de interpretar grandes conjuntos de datos complejos para abordar tareas específicas pero complicadas (por ejemplo, visión artificial).

-

IA generativa: una extensión del aprendizaje profundo que utiliza los llamados modelos de lenguaje y base grandes capaces de generar contenido nuevo para abordar solicitudes de tareas mucho más amplias (por ejemplo, ChatGPT o Gemini).

-

IA agentica: una extensión del aprendizaje profundo y la IA generativa capaz de tomar decisiones autónomas (por ejemplo, el software de piloto automático de Tesla para la conducción autónoma).

-

Este artículo se centra en las nuevas herramientas de IA que utilizan los profesionales sanitarios, los sistemas de salud y las personas con problemas de salud. Las nuevas tecnologías de IA, ampliamente utilizadas en la sociedad, también pueden influir en la salud. Algunos ejemplos son:

-

Las herramientas de IA implementadas en las ciencias de la vida (por ejemplo, herramientas para mejorar el descubrimiento de fármacos, mejorar la realización de ensayos aleatorios o interrogar datos de atención médica) podrían mejorar el descubrimiento biomédico.

-

Las herramientas de IA implementadas para abordar factores sociales (por ejemplo, herramientas para mejorar la asequibilidad de la vivienda o la seguridad alimentaria) podrían alterar la salud en el futuro.

-

Las herramientas de IA utilizadas ampliamente en la comunicación e interacción social (por ejemplo, algoritmos implementados en plataformas de redes sociales) podrían afectar la salud mental, difundir información (o desinformación) sobre la salud y la atención médica e influir en aspectos del comportamiento de búsqueda de atención, como las actitudes sobre la vacunación.

-

El uso de trucos generales de eficiencia por parte de científicos biomédicos y profesionales de la salud, como el uso de ChatGPT para redactar informes biomédicos o Gemini para búsquedas en Internet, podría afectar la forma en que se resume, distribuye y utiliza la información médica.

Para garantizar que la innovación en IA se fomente y se incorpore adecuadamente en la prestación de servicios de salud, se requiere una alineación sobre cómo abordar estos desafíos entre los desarrolladores de IA, los sistemas y profesionales de la salud, los pagadores, los reguladores y los pacientes. 4 , 5 , 7 Una Cumbre de JAMA convocó a múltiples partes interesadas para revisar el estado actual de la IA en la salud y la atención médica, centrándose en la mejor manera de evaluar, regular y monitorear las herramientas y tecnologías de IA y las implicaciones para la infraestructura y la fuerza laboral de la atención médica. La IA puede influir en la salud y la atención médica de muchas maneras ( Recuadro ), pero limitamos la discusión a las herramientas y tecnologías utilizadas por los médicos, los pacientes y las personas con problemas de salud o bienestar, y los sistemas de atención médica ( Tabla 1 ). Aunque la IA es un término amplio que puede incluir tecnologías más antiguas similares a las de las aplicaciones tradicionales de soporte de decisiones estadísticas y basadas en computadora, la discusión se limitó a avances más recientes, como los modelos de aprendizaje automático que utilizan métodos de conjunto, aprendizaje profundo, IA generativa e IA agentica ( Recuadro ). 8 Usamos el término herramienta de IA para representar cualquier herramienta, tecnología, dispositivo o aplicación que contenga dicha IA.

| Clínico | Directo al consumidor | Operaciones comerciales | Híbrido | |

|---|---|---|---|---|

| Descripción | Herramientas de IA utilizadas por un médico para respaldar decisiones de diagnóstico o tratamiento | Herramientas de IA utilizadas por una persona con problemas de salud o bienestar, sin interactuar necesariamente con ningún sistema de atención médica o profesional. | Herramientas de IA utilizadas por un sistema o profesional de la salud para optimizar aspectos de la prestación de servicios de salud. | Herramientas de IA que sirven para múltiples propósitos (por ejemplo, operaciones clínicas y comerciales) |

| Oportunidad | Mejorar los resultados de los pacientes mediante:

Mejor acceso a la atención, precisión diagnóstica y cumplimiento de las pautas de mejores prácticas Atención más personalizada |

Mejorar la salud de los pacientes y de la población mediante:

Mejora de la vigilancia y la gestión de las enfermedades Ayudar a las personas a adoptar estilos de vida saludables y estrategias de prevención. Acceso más rápido, más personalizado y/o menos costoso a la atención |

Mejorar la prestación de servicios de salud mediante:

Automatización de procesos que requieren mucha mano de obra Reducción de la carga administrativa Reducción de residuos Mejora de la generación de ingresos |

Mejorar la prestación de servicios de salud mediante:

Reducción de la carga administrativa para los profesionales sanitarios Ayudar a los profesionales de la salud a ejecutar tareas de atención Ayudar a los pacientes a navegar por las opciones de prestación de atención médica |

| Ejemplos | Software de IA para la detección autónoma de la retinopatía diabética

Software integrado en máquina de ecografía cardíaca portátil que proporciona diagnóstico automatizado Algoritmo basado en EHR que genera alertas de sepsis con indicaciones de tratamiento |

Aplicación para teléfonos inteligentes que diagnostica y trata afecciones de la piel.

Chatbot que ofrece apoyo en salud mental Algoritmo que utiliza datos del biosensor del smartwatch para detectar caídas o arritmias |

Algoritmo que utiliza datos de EHR para optimizar la codificación para la facturación

Software para optimizar la gestión de la cadena de suministro Software para optimizar la programación de pacientes y personal |

IA ambiental que transcribe conversaciones entre pacientes y médicos para generar notas, facturas y planes de tratamiento.

Modelo de lenguaje grande que responde a mensajes seguros del paciente Navegador de pacientes basado en la web que ayuda a programar citas según las inquietudes del paciente. |

| Tendencias actuales | Numerosas evaluaciones publicadas

Esfuerzos considerables para proporcionar supervisión regulatoria Alta adopción en imágenes médicas Alta disponibilidad pero adopción variable de herramientas EHR integradas Baja adopción fuera de las imágenes y la historia clínica electrónica con preocupaciones sobre la confianza, la eficacia, la seguridad y los costos de implementación |

Gran cantidad de aplicaciones y descargas

Hay pocos datos sobre los efectos en la salud y algunas preocupaciones sobre la seguridad y la eficacia. Supervisión regulatoria muy limitada, especialmente en lo que respecta a los efectos sobre la salud El modelo de negocio óptimo no está claro Poca integración entre productos o con la prestación de servicios de salud |

Mercado en rápido crecimiento, con amplia adopción por parte de los sistemas de atención médica.

Evaluación muy limitada de los efectos sobre la salud Supervisión regulatoria limitada Preocupaciones expresadas por los médicos sobre los efectos adversos en los pacientes |

Mercado en rápido crecimiento, con amplio interés y adopción por parte de los sistemas de atención sanitaria.

Evaluación muy limitada de los efectos sobre la salud Supervisión regulatoria limitada Preocupaciones expresadas por los médicos sobre los efectos adversos en los pacientes |

La mayoría de las herramientas de IA en la literatura médica caen dentro de la categoría de herramientas clínicas (es decir, herramientas que apoyan directamente las actividades clínicas de los profesionales de la salud). Los ejemplos incluyen software de IA para la detección automatizada de la retinopatía diabética, software de IA integrado en un dispositivo de ecocardiografía portátil para proporcionar un diagnóstico automatizado o un algoritmo de aprendizaje automático que escanea el registro de salud electrónico (EHR) para proporcionar alertas de sepsis y recomendaciones de tratamiento. 9 – 19 Muchas de estas herramientas requieren la autorización de la Administración de Alimentos y Medicamentos de los EE. UU. (FDA) como dispositivos médicos, y más de 1200 han sido autorizadas, la mayoría de las cuales están en imágenes médicas. 7 , 20 La IA ha transformado las imágenes médicas, aumentando la interpretación de las imágenes y cambiando drásticamente la forma en que trabajan los radiólogos y patólogos, con la adopción de algún tipo de IA por parte del 90% de los sistemas de atención médica de los EE. UU. 1 , 21 – 23 Las herramientas de soporte de decisiones clínicas basadas en IA integradas en el EHR también están ampliamente disponibles, en parte porque algunas han estado fuera de la supervisión de la FDA y porque el costo para un sistema de atención médica de tener la herramienta activada puede percibirse como modesto. 23 A pesar del buen acceso a estas herramientas de IA nativas de EHR, persiste la preocupación entre los médicos y los sistemas de atención médica con respecto a su precisión, valor y utilidad. 23 , 24

Más allá de las aplicaciones de imágenes médicas y de la historia clínica electrónica (HCE), la difusión de las herramientas de IA clínica ha sido más lenta. La principal barrera probablemente sea que los sistemas de salud responsables de adquirir estas herramientas no creen que ofrezcan suficiente valor. Los costos, no solo de licenciar una herramienta, sino también de garantizar una capacitación, infraestructura digital, mantenimiento y monitoreo adecuados, pueden ser considerables. 23 , 25 , 26 No hay reembolso para la mayoría del uso de herramientas de IA e, incluso en casos selectos cuando las aseguradoras ofrecen reembolso, este no compensa los costos totales. 27 También puede haber escepticismo sobre si los supuestos beneficios se materializarán en la práctica. Las preocupaciones sobre el sesgo algorítmico, el sesgo de automatización (favorecer las sugerencias de los sistemas automatizados mientras se pasa por alto información contradictoria ), la falta de generalización y la confianza y el respaldo insuficientes de los médicos y los pacientes pueden frenar aún más el entusiasmo de los sistemas de salud. 23 , 24 , 28-32

Existe un entusiasmo considerable entre el público por las herramientas de IA DTC (es decir, herramientas utilizadas por pacientes o personas con inquietudes sobre la salud o el bienestar). 33 – 35 Los ejemplos incluyen una aplicación que accede a la cámara de un teléfono inteligente para ayudar a una persona a autodiagnosticarse una afección dermatológica, un chatbot que ofrece apoyo en materia de salud mental y un algoritmo que utiliza datos de biosensores de un reloj inteligente para detectar caídas o arritmias. 36 – 39 Actualmente, existen más de 350 000 aplicaciones de salud móvil, con IA frecuentemente incorporada en el software. 35 , 40 Tres de cada 10 adultos en todo el mundo han utilizado una aplicación de salud móvil, y el mercado ya supera los 70 000 millones de dólares anuales. 35 Aunque algunos productos, como los que monitorean las arritmias, están regulados por la FDA, las empresas a menudo pueden etiquetar las herramientas DTC como productos de bienestar general de bajo riesgo y pueden evitar los requisitos regulatorios o de informes. 33 , 41 , 42 La mayoría de estas herramientas no se conectan con la empresa de prestación de servicios de salud, lo que limita la capacidad de los profesionales de la salud para acceder a los datos y revisar o coordinar recomendaciones. Las herramientas que sí interactúan con los profesionales de la salud requieren una inversión inicial considerable para garantizar que los datos se integren adecuadamente. Algunas aseguradoras de salud han fomentado el uso de aplicaciones de bienestar DTC mediante cobertura de suscripción o incentivos de recompensa, pero la mayoría de los usos no se reembolsan. 43-45 Otras barreras incluyen la falta de evidencia de alta calidad sobre los beneficios para la salud; las preocupaciones sobre la confianza, la usabilidad y la privacidad; la integración (o no) con los sistemas de atención médica; y la incertidumbre sobre el modelo de negocio adecuado. 46 , 47 Sin embargo, a medida que se superan o eluden estas barreras, estas herramientas, al eludir gran parte de la infraestructura existente de la atención médica tradicional, pueden representar una innovación verdaderamente disruptiva. 48

Los sistemas de atención médica están adquiriendo rápidamente herramientas de IA para aumentar la eficiencia del sistema y los márgenes operativos. 2 , 49 , 50 Los ejemplos incluyen software de IA para optimizar la capacidad de camas, la gestión del ciclo de ingresos, la programación de pacientes y personal, la cadena de suministro y los requisitos de informes. 2 , 49-57 Un ejemplo popular es el uso de IA por parte de los sistemas de atención médica para generar solicitudes de autorización previa y, quizás no sea sorprendente que las aseguradoras estén adoptando de manera similar herramientas de IA para evaluar esas solicitudes. 58-60 El uso de IA para mejorar las operaciones comerciales ya está arraigado en muchas industrias. 61 Sin embargo, las consecuencias para los pacientes cuando las organizaciones de prestación de servicios de atención médica adoptan estas herramientas no se comprenden bien. Por ejemplo, si un sistema de atención médica implementa software de IA para optimizar la programación de quirófanos, podría haber grandes efectos (buenos o malos) en los costos de personal y en el acceso a intervenciones quirúrgicas urgentes. Aunque los cambios en el acceso pueden afectar los informes de calidad de los hospitales, es posible que no se detecte la atribución de estos cambios a la herramienta porque su uso, al igual que otras estrategias operativas de atención médica, no requiere ninguna evaluación ni revisión regulatoria.

Muchas herramientas de IA respaldan tanto las operaciones comerciales como algunos aspectos de la atención clínica o la experiencia del paciente. Por ejemplo, los llamados escribas de IA que escuchan las conversaciones entre pacientes y médicos ayudan en las operaciones generando notas y facturas (lo que reduce la carga de documentación) al mismo tiempo que brindan apoyo clínico, como ofrecer posibles diagnósticos o recomendaciones de tratamiento para su verificación. De manera similar, una herramienta de navegación de pacientes con IA basada en la web puede atraer a más pacientes a un sistema de atención médica, al tiempo que proporciona una mejor dirección a los profesionales de la salud adecuados, generando ingresos para el sistema y mejorando el acceso de los pacientes. Estas herramientas están siendo adoptadas muy rápidamente por los sistemas de atención médica. 2 , 23 Los escribas de IA en particular, aunque inicialmente se asociaron con resultados mixtos, parecen bien recibidos por pacientes y médicos, especialmente cuando se integran con el EHR. 62 – 65 Cada conversación entre pacientes y médicos en los EE. UU. pronto podría estar acompañada por un agente de IA interactivo en vivo

Derek Angus, MD, MPH, se une al editor en jefe de IA de JAMA+, Roy Perlis, MD, MSc, para analizar una comunicación especial de JAMA Summit: Inteligencia artificial.

En teoría, dada la importancia de los efectos potenciales de las herramientas de IA en los resultados de salud de los pacientes (así como en los costos de atención médica y la fuerza laboral), se deben realizar evaluaciones metodológicamente rigurosas para generar una base de evidencia sólida para informar su difusión (es decir, producción de conocimiento generalizable sobre las condiciones bajo las cuales se logran efectos particulares). 66 , 67 En la práctica, a pesar de la amplia aceptación de que las herramientas de IA pueden tener grandes efectos en la salud, existe un debate considerable sobre qué herramientas requieren evaluación, cómo se deben realizar las evaluaciones y quién es responsable.

La evaluación de las herramientas de IA clínica en publicaciones revisadas por pares parece tener un amplio respaldo. Se requiere evaluación para muchas autorizaciones de la FDA, como el software de novo como vía para dispositivos médicos, y los ejemplos de consecuencias adversas cuando las herramientas de IA se difundieron sin evaluaciones previas revisadas por pares, como las altas tasas de casos perdidos y falsas alarmas por un sistema de alerta de sepsis, provocaron llamados para evaluaciones obligatorias antes de su uso generalizado. 68 , 69 Existen múltiples evaluaciones de las herramientas DTC y, aunque algunas mostraron beneficios, otras plantearon inquietudes de seguridad, como consejos que eran perjudiciales o contrarios a las pautas y una falta de apoyo adecuado durante las crisis de salud mental, lo que provocó demandas de que estas herramientas también se evaluaran de forma rutinaria. 34 , 70 Sin embargo, las herramientas DTC evaluadas hasta la fecha son una fracción minúscula del mercado, y los hallazgos negativos no parecen haber obstaculizado el crecimiento del mercado.

Existen opiniones firmes, pero pocas evaluaciones revisadas por pares, con respecto a los efectos en la salud de las herramientas de operaciones comerciales. Por ejemplo, muchos médicos estadounidenses creen que el uso de herramientas de IA por parte de las aseguradoras para denegar la autorización previa está teniendo consecuencias negativas generalizadas para los pacientes, pero ningún estudio ha examinado si el uso de herramientas de IA ha afectado las tasas de denegación y de qué manera. 60 , 71 , 72 No es sorprendente que las aseguradoras defiendan el uso de dichas herramientas. 73 Aunque las evaluaciones revisadas por pares de las herramientas de operaciones comerciales son poco frecuentes, los testimonios de clientes y los casos de uso, a menudo con afirmaciones combinadas sobre la eficiencia del sistema y la calidad de la atención médica, se utilizan rutinariamente para comercializar estos productos. 74 , 75 Las herramientas de operaciones comerciales para las que se encuentran disponibles evaluaciones publicadas son aquellas con una función híbrida, como los escribas de IA, aunque la evaluación se centra principalmente en la satisfacción del paciente y el médico, y en el flujo de trabajo del médico, en lugar de en los efectos sobre la calidad de la atención médica y los resultados del paciente . 62-65

Muchas partes interesadas creen que todas estas herramientas de IA afectan la salud, pero el impulso para la evaluación revisada por pares de las posibles consecuencias para la salud, y la probabilidad de que sus hallazgos influyan en su adopción, parece ser mayor en las herramientas más cercanas a los profesionales clínicos. La falta de evaluación de los efectos en la salud de las herramientas de operaciones empresariales no es exclusiva de la IA, sino que es consistente con la de todas las estrategias organizacionales de atención médica, a pesar de los llamados al cambio . 76-78

Existen considerables desafíos metodológicos para la generación de conocimiento transferible sobre las consecuencias para la salud de las herramientas de IA en la salud y la atención médica, especialmente cómo definir la intervención y el contexto, identificar el mecanismo de acción, capturar resultados relevantes e inferir causalidad.

Para ser generalizable, cualquier evaluación debe describir cuál es la intervención real y en qué contexto se evalúa. Con una herramienta de IA, la intervención es tanto el software de IA como su paquete de entrega: la interfaz humano-computadora y la capacitación que la acompaña. Una interfaz humano-computadora deficiente o la falta de capacitación podrían disminuir considerablemente la efectividad de la herramienta. El contexto incluye tanto la tarea que el usuario está abordando como el entorno. Algunas herramientas son bastante específicas de la tarea (p. ej., una alerta de sepsis), pero para las herramientas de IA generativas o agenciales capaces de ayudar en muchas tareas, definir exactamente qué tareas se están abordando en una evaluación particular puede ser un desafío. Incluso cuando la tarea es limitada, el rendimiento de una herramienta puede variar considerablemente según el entorno. 79 Por ejemplo, la efectividad de una alerta de sepsis puede depender del lugar de implementación (departamento de emergencias vs. sala de hospital; hospital comunitario vs. hospital docente), cómo se incorpora al flujo de trabajo y muchas otras actividades y prioridades de apoyo y competencia en el lugar de trabajo. 80 , 81 La intervención y el contexto de las herramientas DTC también pueden ser muy difíciles de definir, dada la amplia gama potencial de características relevantes del usuario (p. ej., alfabetización digital), las opciones de personalización del software y, especialmente para la IA generativa y agente, la amplitud de las tareas. Definir la aplicación y el contexto de los casos de uso para las herramientas de operaciones comerciales de forma generalizable es igualmente difícil.

Muchos de estos desafíos son bien conocidos en la evaluación de cualquier servicio de salud complejo o intervención de prestación, y existen enfoques bien aceptados en la investigación de servicios de salud y la ciencia de la implementación para abordarlos. Sin embargo, la ciencia de la prestación de servicios de IA presenta problemas relativamente singulares. 82 Por ejemplo, existen estrategias para incorporar en una evaluación cómo la curva de aprendizaje de un usuario influye en el efecto de una intervención compleja, pero estas estrategias suelen asumir que la herramienta es estática. Con algunas herramientas de IA, existe la complejidad añadida de que la propia herramienta también puede estar aprendiendo (con la mejora o degradación del rendimiento predictivo), lo que a su vez puede cambiar la confianza del usuario.

La generalización se ve facilitada por saber no solo si una intervención funcionó, sino también cómo. En el caso de la IA, la evaluación del funcionamiento de una intervención puede considerarse en tres capas concéntricas. La capa interna es la interpretabilidad de la herramienta, una descripción del modelo matemático que impulsa los procesos de toma de decisiones de la herramienta. Sin embargo, los modelos de IA de aprendizaje profundo, generativos y agentes son tan complejos que las descripciones de su estructura matemática subyacente pueden ser difíciles de interpretar y proporcionar una visión limitada de su probable rendimiento clínico. La capa intermedia es la explicabilidad, donde las decisiones de salida del modelo en diversos entornos (entradas) se utilizan para proporcionar una imagen del comportamiento de la herramienta. La explicabilidad facilita la transparencia cuando la estructura matemática subyacente es difícil de interpretar, pero puede ser difícil saber si el rendimiento del modelo se explica adecuadamente en todas las situaciones razonables que podría encontrar. 83

La explicabilidad suele explorarse a posteriori en los conjuntos de datos existentes, pero la precisión de un modelo de IA cuando se aplica retrospectivamente no es necesariamente indicativa de cómo las decisiones de atención se verán influenciadas por la herramienta en la práctica. 84 Por lo tanto, la capa exterior es una evaluación prospectiva de cómo funciona la herramienta como una intervención real en entornos del mundo real. 85 Idealmente, esta capa evaluaría en qué medida el rendimiento de la herramienta depende de las demás características de la intervención (la interfaz humano-computadora y la capacitación del usuario) y del contexto en el que se implementa la herramienta. Para la IA con amplia aplicabilidad, como las herramientas de IA generativa y agencial, la evaluación exhaustiva de su rendimiento en el mundo real es particularmente desalentadora.

En el caso de las herramientas utilizadas en los sistemas de atención médica (clínicas, operaciones comerciales de atención médica y herramientas de IA híbridas), las consecuencias para la salud se pueden capturar utilizando datos de HCE y enfoques estándar de recopilación de datos de investigación clínica. La experiencia del usuario también puede ser importante y se puede capturar utilizando enfoques estándar de métodos mixtos. El problema no es cómo capturar los resultados relevantes, sino que estos enfoques requieren mucho tiempo y son costosos, pudiendo superar el costo inicial de desarrollar la herramienta. Este problema plantea una doble amenaza: o bien se disuadirá a los investigadores de realizar cualquier evaluación o bien estas serán limitadas, pudiendo omitir resultados clave o restringirse a entornos más factibles (p. ej., un centro médico académico), comprometiendo así la generalización. En el caso de las herramientas DTC, capturar sus efectos en los resultados de salud ha añadido complejidad, especialmente cuando la intención es mitigar eventos raros en individuos que, por lo demás, estarían bien. Por ejemplo, para determinar si una herramienta de IA que utiliza datos de frecuencia cardíaca de un reloj inteligente podría identificar la fibrilación auricular, los investigadores tuvieron que inscribir a más de 400 000 personas y proporcionar un sistema de múltiples capas que incluía un servicio de telesalud a nivel nacional, una evaluación independiente de médicos y mecanismos de derivación a los propios médicos de las personas. 86

En última instancia, el objetivo es comprender el efecto de una herramienta de IA, no simplemente si su uso está asociado con, pero no es la causa de, un resultado particular. El diseño estándar para la inferencia causal en el cuidado de la salud es el ensayo clínico aleatorizado (ECA). Sin embargo, pocas herramientas de IA han sido evaluadas por ECA. 80 , 87 – 91 Los ECA suelen ser costosos, requieren mucho tiempo y se centran en 1 o 2 intervenciones en 1 entorno clínico. Para las herramientas de IA, los diseños de ECA utilizados más comúnmente en la investigación de servicios de salud y la ciencia de la implementación (por ejemplo, diseños de clúster o cuña escalonada con componentes cualitativos integrados) a menudo pueden ser más aplicables. 92 Independientemente de la elección del diseño, si una herramienta de IA se evaluara en todos los casos de uso razonables, cada herramienta podría requerir múltiples ECA. Dado el ritmo al que se desarrollan las herramientas de IA, confiar en los ECA, al menos como se realizan actualmente, como el enfoque predeterminado parece bastante poco práctico. Los diseños de ECA más nuevos, como los ensayos de plataforma y los ensayos integrados en el EHR, pueden permitir ECA más rápidos y económicos. 93 – 100 Cabe destacar que muchas industrias no relacionadas con la atención médica, incluida la industria de seguros, han implementado sistemas para realizar pruebas A/B aleatorias rápidas para evaluar sus herramientas comerciales, especialmente las tecnologías digitales. 66 , 101 – 104 Por el contrario, los sistemas de atención médica rara vez utilizan pruebas A/B aleatorias para evaluar las operaciones comerciales, posiblemente debido a una aversión percibida a la experimentación o creencias de que los datos aleatorios son innecesarios, inútiles o demasiado difíciles de adquirir. 66 , 78 , 105

El enfoque alternativo consiste en utilizar datos observacionales. Por ejemplo, el estudio sobre relojes inteligentes descrito anteriormente utilizó un estudio de cohorte de un solo grupo para caracterizar adecuadamente las características de rendimiento de la herramienta de IA. 86 Al comparar los resultados clínicos de cohortes de personas atendidas con y sin una herramienta de IA, existen numerosos enfoques cuasiexperimentales para facilitar la inferencia causal a partir de datos observacionales, si bien con la salvedad de que a menudo requieren la recopilación de datos adicionales (p. ej., información detallada sobre la variación en el entorno en el que se utiliza la herramienta para permitir la identificación de posibles variables instrumentales) y una amplia experiencia estadística. 92 , 106

Incluso si hubiera un acuerdo sobre la necesidad y el enfoque para una evaluación de los efectos en la salud de una herramienta de IA, no está claro quién es responsable. Para las herramientas que requieren la revisión de la FDA, la evaluación inicial recae en el desarrollador. Sin embargo, la evaluación no incluye necesariamente la evaluación de los efectos en la salud en el mundo real. 107 Para las herramientas exentas de la aprobación de la FDA, los desarrolladores probablemente realizarían evaluaciones acordes con sus afirmaciones. Por ejemplo, un desarrollador de herramientas DTC puede evaluar la lealtad del suscriptor, mientras que un desarrollador de una herramienta de gestión del ciclo de ingresos puede desear demostrar que su herramienta mejora los ingresos. 108 , 109 Sin embargo, en ninguno de los casos el desarrollador evaluará necesariamente las consecuencias para la salud de su herramienta. Las organizaciones de prestación de servicios de salud pueden estar motivadas a realizar sus propias evaluaciones, pero muchas pueden no tener los fondos o la experiencia para realizar evaluaciones exhaustivas. 7 , 110-115 Los gobiernos pueden proporcionar subvenciones para financiar algunas evaluaciones, pero dicha financiación está lejos de ser integral. Los pacientes y las comunidades son partes interesadas que no son responsables de la evaluación, pero cuyas perspectivas son cruciales. Sin embargo, sus perspectivas no se incluyen de forma rutinaria. 116 , 117

Las herramientas de IA para la salud y la atención médica deben estar sujetas a una estructura de gobernanza que proteja a las personas y garantice que las herramientas logren sus beneficios potenciales. Para otras intervenciones de atención médica, la supervisión regulatoria es una parte importante de esa gobernanza, asegurando a la sociedad y a los mercados que una intervención es creíble. Sin embargo, Estados Unidos no cuenta con un marco regulatorio integral y adecuado para el propósito de la IA en la salud y la atención médica. Las razones incluyen la naturaleza diversa y de rápida evolución de la tecnología de IA, las numerosas agencias con jurisdicción sobre diferentes tipos y aspectos de IA, y la falta de marcos regulatorios específicamente diseñados para IA dentro de estas agencias. 41 El desarrollo de medicamentos y dispositivos médicos tradicionales también se beneficia de la armonización internacional de las normas regulatorias. 7 Aunque existen esfuerzos para armonizar las normas para la IA, existen importantes diferencias internacionales. Por ejemplo, las administraciones de Biden y Trump han reducido la carga regulatoria, mientras que la Unión Europea ha promulgado un marco integral para una mayor supervisión regulatoria. 41 , 118 , 119

En los EE. UU., la FDA regula cualquier herramienta de IA clasificada como un dispositivo médico (es decir, una tecnología utilizada para diagnosticar, tratar, mitigar, curar o prevenir una enfermedad o afección), independientemente de si la utiliza un médico o un consumidor. 7 La FDA aplica un enfoque basado en el riesgo y específico de la función para proporcionar la garantía menos onerosa de seguridad y eficacia. Este enfoque incluye determinar en qué tipos de dispositivos centrarse y qué nivel de evidencia se requiere para la comercialización. Aunque la agencia ha revisado los dispositivos habilitados para IA durante muchos años, su alcance está limitado por los recursos y la ley del Congreso. 41 Por ejemplo, la Ley de Curas del Siglo XXI excluye el software (incluido el software de IA) de la definición de dispositivo médico si su función es proporcionar apoyo administrativo (por ejemplo, programación y facturación), apoyo general al bienestar, algunos tipos de apoyo a la toma de decisiones clínicas y una serie de funciones de EHR y gestión de datos. 7 , 120 Como tal, muchas de las herramientas de IA analizadas aquí están exentas de la regulación de la FDA. 120 Incluso en el caso de las herramientas sobre las que la FDA sí tiene autoridad, como se señaló anteriormente, la autorización no necesariamente exige la demostración de mejores resultados clínicos. 107 En particular, las herramientas de IA generativas y agentes pueden ser capaces de realizar tantas tareas como para desafiar seriamente el marco tradicional de uso previsto para la regulación de dispositivos. 3 , 41 Más bien, se parecen más a los profesionales de la salud, lo que plantea la idea de que algún día los estados podrían otorgar licencias a los agentes de IA como médicos digitales.

Las herramientas de IA basadas en HCE que no cumplen con la definición de dispositivo médico están bajo la supervisión del Subsecretario de Política Tecnológica/Oficina del Coordinador Nacional de Tecnología de la Información Sanitaria, que ofrece certificación voluntaria para sistemas de tecnología de la información sanitaria, incluidas las plataformas de HCE, basándose en la demostración de la transparencia, la gestión de riesgos, la fiabilidad y la imparcialidad del producto. 121 De igual manera, algunas herramientas de IA clínica de laboratorio que no cumplen con la definición de dispositivo médico pueden utilizarse a través del programa de enmiendas para la mejora de los laboratorios clínicos de los Centros de Servicios de Medicare y Medicaid (CMS). 122 El uso de algunas herramientas de operaciones comerciales, como el software de autorización previa, también está sujeto a las directrices de los CMS, pero solo cuando lo utilizan entidades sujetas a la regulación de los CMS. 123 Las herramientas de bienestar general DTC están bajo la supervisión de la Comisión Federal de Comercio (FTC), cuyo enfoque se centra en los derechos de privacidad, la seguridad de la información personal y la protección contra la publicidad engañosa y las prácticas injustas o engañosas. 42 En parte para subsanar las deficiencias en la supervisión federal, existen numerosos esfuerzos de regulación y certificación por parte de los gobiernos estatales y las sociedades médicas profesionales. 41

Las características de las herramientas de IA que son difíciles de evaluar y regular también lo son para su implementación y monitoreo. Por ejemplo, para las herramientas utilizadas en los sistemas de atención médica, la alta dependencia de su efectividad en la capacitación y el contexto del usuario significa que los sistemas de atención médica requieren una infraestructura y recursos considerables para garantizar que los usuarios estén capacitados adecuadamente y que la herramienta se utilice en el entorno óptimo. 26 , 110 , 112 Debido a que la herramienta puede estar sujeta a poca evaluación y regulación previa, también pueden faltar pautas sobre cómo garantizar un uso óptimo. 7 Incluso si previamente se demostró que es beneficiosa, es incierto si la herramienta es realmente beneficiosa en un entorno particular o continúa siendo beneficiosa con el tiempo. 7 , 41 , 107 , 110 Sin embargo, sin un tamaño de muestra, infraestructura, experiencia y recursos adecuados, un sistema de atención médica no podrá determinar si su uso de la herramienta es beneficioso y, por lo tanto, cuándo es mejor adoptarla o desadoptarla. En el caso de las herramientas DTC que están fuera de la supervisión de la FDA, pero bajo la jurisdicción de la FTC, los tipos de prácticas que la FTC supervisa son mucho más específicos que el conjunto completo de problemas que pueden surgir de la implementación de la IA y amenazan los intereses de los pacientes y los médicos. Otros componentes de una implementación adecuada son la necesidad de demostrar que el uso de una herramienta es justo y centrado en el paciente (por ejemplo, no es financieramente tóxico), pero demostrar que se cumplen estos criterios no es sencillo. 124-126 El excomisionado de la FDA , Robert Califf, resumió recientemente el problema, afirmando: «He buscado por todas partes y no creo que haya un solo sistema de salud en Estados Unidos capaz de validar un algoritmo de IA implementado en un sistema de atención clínica». 25

Todas las partes interesadas coinciden en que la IA en la salud y la atención sanitaria debe ser justa, apropiada, válida, eficaz y segura. 5 , 24 , 113 , 119 , 121 , 127-140 Sin embargo, crear un entorno que promueva la innovación y la difusión de acuerdo con estos principios será extremadamente difícil. Tres grandes problemas dominan el panorama. En primer lugar, la vía lineal tradicional para las intervenciones en el cuidado de la salud, compuesta por pasos discretos desde el desarrollo y la evaluación, pasando por la autorización regulatoria hasta la difusión monitoreada, cada uno gestionado por partes interesadas específicas, no se ajusta fácilmente a la IA porque las herramientas son muy amplias y flexibles, evolucionan rápidamente y son difíciles de evaluar por completo hasta que se incorporan a la práctica. Muchas herramientas entrarán en la práctica con una evaluación limitada, posiblemente sin revisión regulatoria y, a menos que se adopten nuevos enfoques, se monitorearán solo para el cumplimiento y la seguridad del proceso, no para la eficacia. En segundo lugar, con los métodos y la infraestructura actuales, cualquier intento de imponer enfoques integrales de evaluación, implementación y monitoreo probablemente sería prohibitivamente costoso. En tercer lugar, hay muchas partes interesadas, sin una estructura general de incentivos o rendición de cuentas. Para abordar estas cuestiones será necesario avanzar en cuatro áreas ( Cuadro 2 ).

| Estrategia | Razón fundamental | Ejemplos de implementación |

|---|---|---|

| Involucrar a todas las partes interesadas en la gestión total del ciclo de vida del producto | La ruta secuencial tradicional desde el desarrollo hasta la evaluación, la aprobación regulatoria (si es necesario) y la difusión con monitoreo (si es necesario), con cada paso supervisado por diferentes partes interesadas, no es adecuada para las herramientas de IA.

En particular, no es posible realizar una evaluación completa de las consecuencias para la salud hasta que se difunda la herramienta. Una mayor participación de todas las partes interesadas relevantes en cada fase del ciclo de vida de una herramienta puede aumentar el desarrollo, la difusión y el impacto en la salud. |

• Involucrar a los pacientes y médicos en el diseño y desarrollo

• Asociar a los desarrolladores con los sistemas de atención médica en las evaluaciones de implementación y mitigación de seguridad. • Involucrar a los reguladores, los sistemas de atención de la salud y los desarrolladores en un plan de monitoreo colaborativo, incluida la determinación de la necesidad de capturar las consecuencias para la salud. |

| Desarrollar e implementar las herramientas de medición adecuadas para la evaluación, regulación y seguimiento | Sin nuevos métodos, cualquier esfuerzo por aumentar la supervisión y la garantía probablemente será engorroso, costoso y potencialmente ineficaz.

En particular, no existen buenas herramientas para evaluar de manera rápida y eficiente las consecuencias para la salud de las herramientas de IA en todos los entornos y casos de uso relevantes. |

• Integrar e implementar los enfoques de seguridad y cumplimiento propuestos (por ejemplo, colaboración entre la Comisión Conjunta y la CHAI)

• Desarrollar y promulgar métodos novedosos para facilitar evaluaciones rápidas, eficientes y sólidas de las consecuencias para la salud. • Adoptar normas para evaluar las consecuencias para la salud (no sólo la seguridad) durante el despliegue |

| Construya la infraestructura de datos y el entorno de aprendizaje adecuados | Sin una mejor infraestructura de datos y un entorno de aprendizaje, cualquier esfuerzo por aumentar la supervisión y la garantía probablemente será engorroso, costoso y potencialmente ineficaz.

En particular: La recopilación, el acceso y la interoperabilidad deficientes de datos obstaculizan la capacidad de construir e interrogar de manera rápida y eficiente datos relevantes y representativos a nivel nacional sobre el uso y los efectos de las herramientas de IA. Las instituciones capaces de implementar y evaluar de manera sólida pueden ser poco representativas de muchos entornos importantes |

• Crear un entorno de pruebas de datos de atención médica retrospectivos y representativos a nivel nacional

• Aprenda del programa Sentinel de la FDA y de las iniciativas de aprendizaje del sistema de salud para respaldar la conservación de datos actualizados periódicamente sobre la implementación de herramientas dentro de una cohorte representativa a nivel nacional de sistemas de atención médica. • Crear eventualmente una plataforma federada capaz de realizar evaluaciones prospectivas rápidas capaces de realizar una inferencia causal robusta. • Brindar capacitación y recursos para que los sistemas de atención médica realicen o participen en evaluaciones de las consecuencias para la salud de las herramientas de IA. |

| Crear la estructura de incentivos adecuada | Los incentivos actuales no están bien alineados entre las diferentes partes interesadas, lo que potencialmente obstaculiza el progreso.

Las fuerzas del mercado por sí solas pueden no garantizar el desarrollo y la difusión óptimos de las herramientas de IA Las iniciativas estratégicas enumeradas anteriormente pueden requerir incentivos específicos |

• Fondos federales (por ejemplo, similares a los proporcionados por HITECH) para incentivar a los sistemas de atención médica a adoptar estándares de interoperabilidad de datos.

• Financiación federal de investigación para el desarrollo de nuevos métodos |

El primer paso, respaldado por múltiples agencias gubernamentales y organizaciones no gubernamentales, es reconocer la necesidad de una gestión holística, continua, de múltiples partes interesadas y basada en equipos de las herramientas de IA a lo largo de todo su ciclo de vida, desde el desarrollo hasta la implementación. 7 , 26, 121, 135-138, 141-144 Por ejemplo , una mayor participación de los pacientes y los médicos con los desarrolladores en las fases de diseño y desarrollo de una herramienta de IA puede mejorar su transparencia y confiabilidad. 26 , 116 , 142 , 144 De manera similar, los desarrolladores pueden ayudar a los sistemas de atención médica con la implementación, el monitoreo y la solución de problemas como las alucinaciones de los modelos. 26 , 142 Y la capacidad de los reguladores para tranquilizar al público sobre la seguridad y la eficacia de las herramientas de IA requiere un compromiso colaborativo tanto con los desarrolladores como con los sistemas de atención médica. 7 , 120 , 143 Estas asociaciones entre múltiples partes interesadas van más allá de las relaciones tradicionales entre vendedor-cliente o desarrollador-regulador, pero serán clave para una gestión exitosa del ciclo de vida total del producto.

Hay muchas normas propuestas y procesos de certificación para herramientas de IA. 145 Por ejemplo, la calidad de una evaluación podría juzgarse utilizando las directrices APPRAISE-AI, CONSORT-AI, DECIDE-AI, SPIRIT-AI o TRIPOD+AI; el diseño de una herramienta, su uso previsto y su rendimiento podrían informarse y etiquetarse, de forma similar a una etiqueta nutricional de la FDA, con una tarjeta modelo, y su uso en el mundo real podría evaluarse localmente por un sistema de atención médica, que a su vez podría certificarse como preparado para IA . 110 , 112 , 128 , 135 , 136 , 146-153 Los enfoques adoptados por los sistemas de atención médica individuales también podrían servir como recursos para otros sistemas. 110 , 112 Juntos, estos enfoques de evaluación y seguimiento podrían proporcionar la denominada algorítmicovigilancia , similar a la farmacovigilancia. 154 Sin embargo, falta evidencia sobre hasta qué punto estas diversas iniciativas son prácticas, sostenibles, adecuadamente accesibles, capaces de ofrecer las garantías que pretenden, o suficientemente integrales, pero no innecesariamente redundantes. Ponerlas a prueba, perfeccionarlas e integrarlas en un paquete integral sería un avance significativo. Un paso en este sentido es la colaboración de la Comisión Conjunta con la Coalición para la IA en Salud (CHAI) para desarrollar e implementar un proceso de certificación para el uso responsable de la IA en los sistemas de atención médica. 155

Dicho esto, los estándares de monitoreo propuestos hasta ahora se enfocan en la seguridad y el cumplimiento del proceso. 110 , 135 , 136 , 153 , 155 , 156 Ninguno aborda cómo se determinará la efectividad (es decir, mejores resultados clínicos) en diferentes entornos y con el tiempo. Efectivamente, existe una suposición tácita de que probar la efectividad es innecesario o está suficientemente demostrado por pruebas previas a la comercialización (y se mantendrá asumiendo que el uso de una herramienta sigue siendo seguro). Aquí, sería útil establecer estándares y brindar capacitación y recursos para que los sistemas de atención médica realicen o participen en evaluaciones de los efectos causales de una herramienta de IA durante su uso (por ejemplo, uso rutinario de diseños de cuña escalonada por lotes aleatorios o series de tiempo interrumpidas no aleatorias). Este enfoque podría extenderse a las herramientas de operaciones comerciales (por ejemplo, establecer estándares y brindar capacitación y recursos para un mayor uso de las pruebas A/B). También se requerirán métodos novedosos para ayudar a los aspectos logísticos y analíticos de estas evaluaciones de inferencia causal, especialmente para herramientas DTC y herramientas basadas en IA generativa o agentiva. Estos métodos de evaluación pueden depender en gran medida de la IA. 106 , 157

La generación de información eficiente, rápida, robusta y generalizable sobre la seguridad y la eficacia de las herramientas de IA requiere una inversión significativa en infraestructura de datos y capacidad analítica. 158 , 159 Algunas preguntas pueden abordarse dentro de un solo sistema de atención médica, pero incluso los sistemas de atención médica grandes y con buenos recursos, con su propia experiencia analítica y especializada en implementación, pueden tener dificultades para realizar análisis rutinarios rápidos pero robustos. Además, muchas evaluaciones, especialmente si tienen como objetivo garantizar que las herramientas de IA son seguras y eficaces en diversos entornos y poblaciones, requerirán datos de múltiples sistemas de atención médica o datos que vinculen las aplicaciones DTC con la atención médica. Organizaciones como CHAI proponen la creación de conjuntos de datos retrospectivos de los sistemas de atención médica asociados. 135 Dichos conjuntos de datos podrían seleccionarse y hacerse accesibles a los desarrolladores como un entorno limitado para el desarrollo de herramientas de IA y la exploración del rendimiento del modelo en diferentes poblaciones y entornos. Sin embargo, la evaluación del uso en el mundo real requiere que se compartan datos sobre el uso de una herramienta, lo que requiere un mecanismo para obtener actualizaciones periódicas de datos e incluir muchos elementos de datos no solo sobre los pacientes y el entorno, sino también sobre el uso de la herramienta y los flujos de trabajo clínicos. CHAI anunció recientemente su intención de expandirse en esta dirección, aunque la gestión de actualizaciones frecuentes de datos con información nueva, posiblemente exclusiva, sobre herramientas específicas será muy difícil. 160 Un sistema de este tipo podría imitar iniciativas de farmacovigilancia como la iniciativa Sentinel, apoyada por la FDA, aunque con información más completa sobre el uso de la herramienta. 136 , 157 , 161 Si bien Sentinel ha tenido éxito, requirió un esfuerzo considerable para garantizar la calidad, la interoperabilidad y el intercambio de datos. 162

Fundamentalmente, cualquier evaluación prospectiva de herramientas de IA, especialmente las que involucran aleatorización, requeriría una colaboración aún más sofisticada e integrada entre los sistemas de atención médica con acceso a datos en tiempo real o casi real. Algunos sistemas de atención médica individuales han creado los datos y la capacidad analítica necesarios para funcionar como un sistema de salud de aprendizaje. 163 En este caso, dicho sistema sería efectivamente una colaboración multicéntrica de sistemas de salud de aprendizaje. Desde un punto de vista práctico, un enfoque de datos federados puede funcionar mejor, donde los datos del sistema de atención médica permanecen en su lugar, reduciendo algunas cargas logísticas y contractuales. Sin embargo, existen muchos desafíos financieros, contractuales y operativos para la creación de dicha colaboración. 158 Dicho esto, si tiene éxito y asumiendo que la colaboración sea representativa de la amplitud de las poblaciones de pacientes y los entornos clínicos observados a nivel nacional, no solo informaría el uso responsable de las herramientas de IA a lo largo de todo su ciclo de vida, sino que también podría respaldar la evaluación de otras intervenciones de atención médica y soluciones de interoperabilidad de datos. 66 , 164 – 166 Una iniciativa de este tipo requeriría apoyo federal, pero se alinea bien con las prioridades del Departamento de Salud y Servicios Humanos. 167 – 170

Toda la motivación para implementar, adoptar y monitorear herramientas de IA para la salud y la atención médica requiere incentivos adecuados para que las partes interesadas relevantes participen. Si se deja como un mercado subregulado, no está claro si se desarrollarán las herramientas correctas, si las herramientas se adoptarán de una manera que maximice sus efectos beneficiosos para la salud y minimice el riesgo, y si sus efectos se medirán adecuadamente. También es posible que las fuerzas del mercado proporcionen incentivos perversos, como la adopción de herramientas que maximizan las ganancias de los desarrolladores o los márgenes operativos del sistema de salud, mientras que inadvertidamente comprometen la calidad de la atención médica o los resultados de salud. 171 Donde hay poca regulación federal, los estados pueden promulgar un mosaico de políticas heterogéneas, lo que hace que el cumplimiento sea demasiado oneroso para los desarrolladores y, por lo tanto, sofoca accidentalmente la inversión. 41 Por lo tanto, parece necesario desarrollar legislación, regulación y diseños de mercado que alineen los incentivos para la participación adecuada de múltiples partes interesadas.

Algunas prioridades pueden lograrse a través del mercado. Por ejemplo, el deseo de involucrar a pacientes y médicos en el codiseño de herramientas de IA puede lograrse espontáneamente si los desarrolladores anticipan que las personas y los sistemas de salud estarán más dispuestos a comprar dichas herramientas. Otras prioridades pueden ser más difíciles de lograr sin palancas políticas específicas. Por ejemplo, los sistemas de atención médica enfrentan costos considerables para mantener la infraestructura digital y la experiencia técnica requerida para garantizar que cumplen con los estándares de uso responsable o para colaborar en iniciativas de aprendizaje federado. Si bien algunos sistemas de atención médica pueden realizar las inversiones necesarias en respuesta a las fuerzas del mercado, como la oportunidad de fomentar asociaciones comerciales con desarrolladores u obtener ventaja sobre la competencia, una inversión más uniforme por parte de todos los sistemas puede requerir palancas gubernamentales más fuertes, como incentivos financieros o requisitos regulatorios. Un modelo potencial es la Ley de Tecnología de la Información de Salud para la Salud Económica y Clínica: aunque persisten numerosos desafíos con la información de salud digital, es notable que una inversión federal relativamente modesta de $35 mil millones llevó a la adopción de EHR por más del 97% de los sistemas de atención médica en una década. 167 , 172 También podrían requerirse fondos federales de investigación para desarrollar métodos de evaluación robustos y eficientes para herramientas de IA en entornos reales, fomentando la colaboración entre desarrolladores, expertos en investigación e implementación de servicios de salud y sistemas de atención médica. Las fuerzas del mercado de la atención médica a menudo no logran brindar una atención adecuada a las poblaciones vulnerables sin la intervención del gobierno, y lo mismo probablemente ocurrirá con el uso responsable de la IA en entornos de bajos recursos. También es probable que una mayor transparencia con respecto a los efectos en la salud de las herramientas de DTC o de operaciones comerciales requiera una mayor regulación.

El impacto de la IA en la fuerza laboral de atención médica será de amplio alcance. Los médicos pueden estar entusiasmados con los beneficios potenciales, preocuparse por el desplazamiento laboral y disfrutar o resistirse a los requisitos para mejorar su alfabetización en IA. También pueden tener preocupaciones existenciales como la falta de alineación de la ética, los objetivos y los principios humanos y de la IA. Aunque su comodidad con la IA está aumentando, los médicos estadounidenses culpan a la falta de supervisión regulatoria como la razón principal de su falta de confianza y adopción de herramientas de operaciones comerciales tanto clínicas como de atención médica. 72 Los sindicatos de trabajadores de la salud también están planteando preocupaciones sobre la IA insegura y poco regulada. 140 La composición de la fuerza laboral también puede necesitar cambiar, agregando más expertos en el desarrollo, la implementación y la evaluación de herramientas de IA. 173 , 174 Y, por supuesto, las herramientas de IA tienen el potencial de aumentar la cantidad de médicos que trabajan, aunque con advertencias clave.

En primer lugar, las herramientas de IA pueden cambiar qué profesional de la salud realiza cada tarea. Por ejemplo, un ecocardiógrafo portátil con interpretación basada en IA mejora las habilidades del técnico de ultrasonido, eliminando potencialmente la necesidad de la interpretación por parte de un cardiólogo o radiólogo. 10 El beneficio es un mejor acceso para los pacientes al ayudar a cerrar las brechas en la atención, especialmente en entornos desatendidos. Sin embargo, estas herramientas podrían generar fricción entre los grupos de profesionales de la salud, por ejemplo, al cuestionar el alcance de las regulaciones de la práctica. También pueden cambiar las habilidades requeridas de los diferentes profesionales de la salud, como la alfabetización en IA. Para anticipar y gestionar estos cambios, los sistemas de salud deben pensar más allá de capacitar a un profesional de la salud en el uso de una herramienta de IA en particular y, en su lugar, replantear las estructuras organizativas, la composición de la fuerza laboral, la distribución de habilidades y la rendición de cuentas en todos los niveles jerárquicos. Por supuesto, el ejemplo más extremo sería cuando una herramienta DTC elimina por completo la necesidad de que una persona busque atención profesional. Este potencial variará considerablemente según el problema de salud y, por lo tanto, afectará a las especialidades de manera muy diferente, pero dicha disrupción parece inevitable.

En segundo lugar, más allá del aprendizaje enfocado en el uso de cualquier herramienta en particular, es necesario incluir una comprensión fundamental de la IA para los profesionales de la salud, tanto en la capacitación como en la educación continua. 175 – 178 Aunque muchas herramientas clínicas pueden proporcionar información que un profesional de la salud puede usar sin comprender la tecnología subyacente (p. ej., tomografía computarizada o secuenciación del genoma completo), las herramientas de IA no solo proporcionan información, sino que también contribuyen al juicio en condiciones de incertidumbre. Por lo tanto, los profesionales de la salud deben comprender mejor las fortalezas y debilidades de su propia toma de decisiones y las susceptibilidades y consecuencias no deseadas al compartir tareas de juicio con una herramienta de IA. Estos requisitos de aprendizaje también se aplican a los administradores de atención médica que utilizan herramientas de IA para operaciones comerciales.

En tercer lugar, las nuevas tecnologías suelen estar primero disponibles y ser adoptadas por personas y organizaciones con mayores recursos. Para que las herramientas de IA se desarrollen y difundan de forma justa y equitativa, y no profundicen la brecha digital, cualquier iniciativa de educación y reorganización debe incluir a los sectores de la atención sanitaria responsables de los grupos más vulnerables. Por supuesto, las iniciativas para garantizar un acceso equitativo a la IA también deben ser conscientes de los riesgos de implementar una herramienta con posibles consecuencias adversas en entornos con escasa capacidad para detectarlas.

En cuarto lugar, muchas herramientas de IA tienen como objetivo reducir la carga administrativa de los profesionales de la salud (p. ej., documentación de registros médicos o apelaciones de autorización previa) bajo la premisa de que esta carga contribuye al agotamiento, la baja moral y el estrés. Sin embargo, esta línea de razonamiento puede tener fallas. En primer lugar, el agotamiento, la baja moral y el estrés son problemas complejos; es mucho pedir que una herramienta de IA los solucione. 179 En segundo lugar, si se liberan de las tareas administrativas, se puede pedir a los médicos que vean más pacientes, lo que también podría causar agotamiento. En tercer lugar, centrarse en herramientas para automatizar tareas como la autorización previa potencialmente pierde la oportunidad más grande de repensar por completo el propósito y el valor de tales tareas.

En quinto lugar, dado que el desarrollo y la difusión óptimos de herramientas de IA requieren una integración mucho mayor con la atención médica que la que requiere el desarrollo de tecnologías tradicionales, los profesionales sanitarios deberán comprender que participan en el ciclo continuo de aprendizaje, mejora y evaluación de estos productos. Si bien los profesionales sanitarios utilizan medicamentos y dispositivos tradicionales fuera de indicación, el grado de incertidumbre sobre los beneficios y los perjuicios de una herramienta de IA puede ser considerablemente mayor. Mientras los profesionales sanitarios sepan que tienen voz en este esfuerzo, sus contribuciones para mejorar el rendimiento de las herramientas de IA podrían ser una fuente de satisfacción laboral.

Aunque no se analizan en detalle aquí, importantes cuestiones éticas y legales afectarán la adopción de la IA en el ámbito de la salud y la atención sanitaria. Un tema importante son los derechos, la privacidad y la propiedad de los datos. Los datos de salud y atención sanitaria son un combustible esencial para las herramientas de IA. Si bien se puede determinar el origen de estos datos, no está claro quién posee o debería poseerlos, especialmente cuando se agregan y transforman, ni qué derechos de privacidad y uso se extienden o deberían extenderse a quién. 180 La Ley de Portabilidad y Responsabilidad del Seguro Médico y la ley de propiedad intelectual de EE. UU. ofrecen cierta orientación sobre los derechos de privacidad, las obligaciones de seguridad, los secretos comerciales y la propiedad de las herramientas desarrolladas a partir de datos, pero son menos claras sobre la propiedad de los datos subyacentes y no protegen contra la aparición de mercados oscuros, no reflejan todas las consideraciones éticas ni se alinean plenamente con la legislación estatal o internacional, como la Ley de IA y el Reglamento General de Protección de Datos de la UE . 180-187

Una segunda cuestión es cómo proporcionar una supervisión ética de la IA a medida que se implementa. 188 Un argumento es que las decisiones de los sistemas de atención médica para implementar herramientas de IA son parte de las operaciones de atención clínica. 189 , 190 Cualquier evaluación del éxito o no de la implementación es una mejora de la calidad, no una investigación, y está exenta de la supervisión ética requerida para la investigación con sujetos humanos. 191 El argumento alternativo es que la implementación de herramientas de IA se implementa en condiciones de incertidumbre, y el objetivo de cualquier evaluación es generar conocimiento que beneficiaría a futuros pacientes. 192 Por lo tanto, dichas evaluaciones son investigación, incluso si también son una mejora de la calidad, y deben caer dentro del ámbito de la junta de revisión institucional local y los principios de la Regla Común. 66 , 193 Actualmente, se dan ambos enfoques, lo que refleja el debate más amplio sobre la mejor manera de proporcionar una supervisión ética de los sistemas de salud en aprendizaje. 66 , 194 – 196 Un aspecto adicional de este problema es que, independientemente de qué organismo proporcione la supervisión (una junta de revisión institucional u otro), la competencia requerida para supervisar la implementación ética de la IA puede faltar si no se cuenta con la infraestructura, los recursos y la capacitación adecuados. 110 , 112 , 197

Finalmente, hasta ahora el uso de herramientas de IA ha sido en gran medida voluntario. Sin embargo, a medida que sus beneficios se vuelven más establecidos, el no uso de una herramienta de IA puede considerarse poco ético o una violación de la atención estándar. Por lo tanto, un sistema o profesional de la salud puede ser responsable en una demanda por mala praxis por no usar IA. 198 , 199 Al mismo tiempo, si un demandante demanda por un resultado adverso cuando se proporcionó atención en la que estuvo involucrada una herramienta de IA, surge la pregunta de si la responsabilidad recae en el profesional de la salud, el sistema de atención médica o el desarrollador de la herramienta. Aunque la jurisprudencia relevante actualmente es limitada, los desarrolladores, los sistemas de atención médica y los profesionales de la atención médica tendrán que adoptar estrategias para gestionar su riesgo de responsabilidad. 139 , 200 Estos ejemplos son solo algunos de los muchos problemas nuevos que deberán abordarse a medida que la IA se incorpore más en la salud y la atención médica.

La IA revolucionará enormemente la salud y la prestación de servicios de salud en los próximos años. Los enfoques tradicionales para evaluar, regular y supervisar las nuevas intervenciones sanitarias están siendo llevados al límite, especialmente con la IA generativa y agente, y sobre todo porque los efectos de estas herramientas no pueden comprenderse plenamente hasta su aplicación práctica. No obstante, muchas herramientas ya se están adoptando rápidamente, en parte porque abordan importantes dificultades para los usuarios finales. Dados los numerosos problemas de larga data en la atención sanitaria, esta disrupción representa una oportunidad increíble. No obstante, la probabilidad de que esta disrupción mejore la salud de todos dependerá en gran medida de la creación de un ecosistema capaz de generar conocimiento rápido, eficiente, sólido y generalizable sobre las consecuencias de estas herramientas en la salud.

Aceptado para publicación: 5 de septiembre de 2025.

Publicado en línea: 13 de octubre de 2025. doi:10.1001/jama.2025.18490

Autor correspondiente: Derek C. Angus, MD, MPH, Medicina de cuidados críticos, UPMC, 3550 Terrace St, 614 Scaife Hall, Pittsburgh, PA 15261 ( angusdc@upmc.edu ).